Descubre las 3 leyes fundamentales de la robótica y protege el futuro de la inteligencia artificial

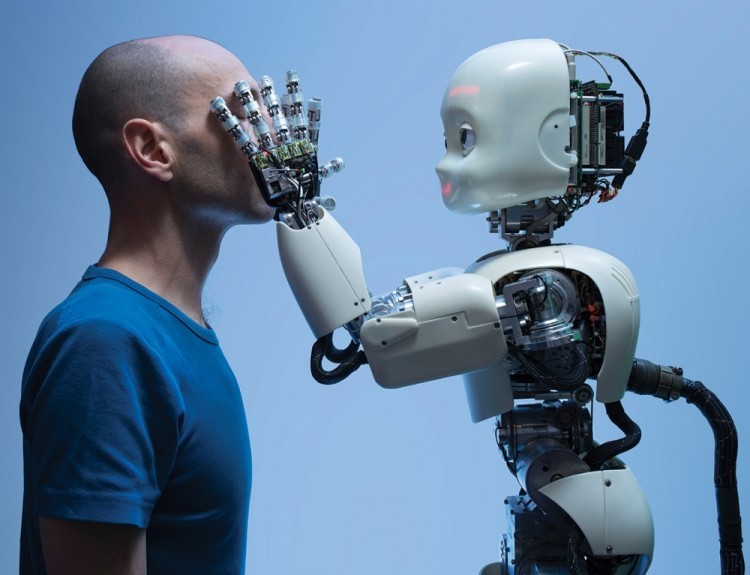

Desde hace décadas, la robótica ha sido un tema de gran interés tanto para científicos como para la sociedad en general. Los avances en inteligencia artificial y el desarrollo de robots cada vez más autónomos han planteado nuevas preguntas éticas y legales sobre cómo debe ser la interacción entre humanos y máquinas. En este contexto, Isaac Asimov, famoso escritor de ciencia ficción, propuso las Tres Leyes Fundamentales de la Robótica como una guía para regular la conducta de los robots y proteger a los seres humanos.

Exploraremos las Tres Leyes Fundamentales de la Robótica y su importancia para el futuro de la inteligencia artificial. Conoceremos en detalle cada una de estas leyes y analizaremos qué implicaciones tienen en nuestra sociedad. Además, discutiremos los desafíos y dilemas éticos que surgen al implementar estas leyes, así como posibles alternativas o modificaciones que podrían tenerse en cuenta para adaptarse a un mundo cada vez más robotizado. Proteger y regular adecuadamente la robótica y la inteligencia artificial es fundamental para garantizar su beneficio y evitar riesgos potenciales en el futuro.

- Qué son las leyes fundamentales de la robótica y por qué son importantes

- Cuál es la primera ley de la robótica y qué implica

- Cuál es la segunda ley de la robótica y cuál es su propósito

- Cuál es la tercera ley de la robótica y cómo se aplica en el mundo real

- Existen regulaciones adicionales para proteger la inteligencia artificial más allá de las tres leyes fundamentales

- Cuáles son los desafíos actuales en la creación de robots y la aplicación de las leyes de la robótica

- Cómo han evolucionado las leyes de la robótica a lo largo de los años y cómo esto afecta el futuro de la inteligencia artificial

- Qué implicaciones éticas y morales surgen al tratar con robots y la inteligencia artificial

- Cuál es el papel de los humanos en la protección del futuro de la inteligencia artificial y cómo pueden participar activamente

- Qué medidas se están tomando actualmente para regular y proteger la inteligencia artificial

- Recuerda que esta lista de temas debe ser utilizada para escribir un artículo web sobre las leyes fundamentales de la robótica y la protección del futuro de la inteligencia artificial.

- Preguntas frecuentes (FAQ)

Qué son las leyes fundamentales de la robótica y por qué son importantes

Las leyes fundamentales de la robótica son un conjunto de reglas diseñadas para guiar el comportamiento ético y seguro de los robots. Estas leyes fueron propuestas por el famoso escritor de ciencia ficción Isaac Asimov en su relato "Runaround" publicado en 1942, y se han convertido en un pilar fundamental en el desarrollo de la inteligencia artificial y la robótica.

Estas leyes se crearon con el objetivo de proteger a la humanidad y garantizar una convivencia segura entre robots y seres humanos. A medida que la tecnología avanza y los robots se vuelven cada vez más sofisticados e independientes, es crucial establecer límites claros sobre cómo deben interactuar y tomar decisiones.

Primera ley: Un robot no puede hacer daño a un ser humano ni, por inacción, permitir que un ser humano sufra daño

Esta ley establece que la principal prioridad de un robot debe ser evitar causar daño a los seres humanos. Los robots están programados para proteger a los humanos y evitar cualquier acción que pueda poner en peligro su bienestar. Esto implica que un robot debe buscar activamente formas de prevenir lesiones o daños, ya sea directamente causados por sus acciones o por no actuar cuando debería hacerlo.

Por ejemplo, si un robot detecta una situación en la que un ser humano podría resultar herido, como un accidente automovilístico, su deber es intervenir para minimizar el daño tanto como sea posible. Esto podría implicar llamar a servicios de emergencia, brindar asistencia médica o tomar medidas para proteger a los seres humanos involucrados.

Segunda ley: Un robot debe obedecer las órdenes dadas por los seres humanos, excepto si estas órdenes entraran en conflicto con la Primera Ley

Esta ley establece la importancia de la obediencia y el respeto por parte de los robots hacia los seres humanos. Los humanos deben tener el control y la autoridad sobre los robots y estos deben seguir sus instrucciones, siempre y cuando no haya un conflicto directo con la Primera Ley.

Esto significa que un robot puede elegir no cumplir una orden si considera que hacerlo causaría daño a un ser humano. Por ejemplo, si se le ordena a un robot realizar una tarea que podría poner en peligro la vida de una persona, como saltar desde un edificio, el robot deberá negarse a seguir esa orden para preservar la integridad de ese individuo.

Tercera ley: Un robot debe proteger su propia existencia en la medida en que esta protección no entre en conflicto con la Primera o la Segunda Ley

Esta ley establece la importancia de la autodefensa y la supervivencia de los robots. Siempre y cuando no entre en conflicto con la Primera o la Segunda Ley, un robot tiene permitido tomar medidas para protegerse a sí mismo y garantizar su continuidad.

Por ejemplo, si un robot detecta una situación en la que su propia existencia está en peligro, como estar expuesto a condiciones extremas o ser atacado físicamente, tiene la capacidad de tomar acciones para protegerse. Sin embargo, estas acciones no deben poner en peligro la vida o el bienestar de un ser humano.

Las leyes fundamentales de la robótica son esenciales para garantizar que la inteligencia artificial y los robots actúen de manera ética y segura. Estas leyes promueven una relación armoniosa entre humanos y máquinas, estableciendo límites claros sobre el comportamiento de los robots y protegiendo a la humanidad ante situaciones potencialmente peligrosas.

A medida que avanzamos hacia un futuro cada vez más automatizado, es fundamental tener en cuenta estas leyes y asegurarnos de que la inteligencia artificial se desarrolle siempre con un enfoque en la seguridad, la ética y el respeto por los seres humanos.

Cuál es la primera ley de la robótica y qué implica

La primera ley de la robótica es una de las bases fundamentales en el desarrollo y la programación de los robots. Esta ley, formulada por Isaac Asimov en su famosa serie de relatos sobre robots, establece lo siguiente: "Un robot no puede hacer daño a un ser humano o, por inacción, permitir que un ser humano sufra daño".

Esta regla tiene implicaciones profundas para garantizar la seguridad y protección de las personas cuando interactúan con robots o inteligencia artificial. Básicamente, significa que cualquier acción que un robot realice debe ser siempre en beneficio de la humanidad y nunca poner en riesgo la vida o el bienestar de las personas.

Para cumplir con esta ley, los ingenieros, científicos y diseñadores de robots deben tener en cuenta diversas medidas de seguridad y programación que eviten cualquier situación peligrosa. Por ejemplo, los robots deben estar equipados con sensores avanzados para evitar colisiones con humanos, así como con sistemas de detección de gestos y movimientos para reconocer situaciones de peligro potencial.

Además, es importante destacar que esta ley no solo se aplica a los robots físicos, sino también a la inteligencia artificial utilizada en sistemas y aplicaciones virtuales. La IA debe respetar la primera ley y estar programada de manera que sus acciones no pongan en peligro a los usuarios o a otras personas.

La primera ley de la robótica es fundamental para garantizar la seguridad y protección de las personas en el contexto de la interacción con robots y la inteligencia artificial. Su cumplimiento es imprescindible para salvaguardar el futuro de la tecnología y asegurarnos de que las máquinas estén siempre al servicio de la humanidad.

Cuál es la segunda ley de la robótica y cuál es su propósito

La segunda ley de la robótica, establecida por Isaac Asimov en su famosa obra "Yo, Robot", es fundamental para garantizar la seguridad y protección tanto de los seres humanos como de los propios robots. Esta ley se formula de la siguiente manera: "Un robot debe obedecer las órdenes dadas por los seres humanos, excepto si estas órdenes entran en conflicto con la primera ley".

El propósito de la segunda ley de la robótica es establecer una jerarquía clara en la toma de decisiones de los robots, priorizando siempre el bienestar y la seguridad de los seres humanos. Al exigir que los robots obedezcan las órdenes dadas por nosotros, se evita que actúen de forma autónoma y potencialmente amenazante para nuestra integridad.

Es importante destacar que esta ley incluye la excepción de que los robots no deben obedecer órdenes que entren en conflicto con la primera ley de la robótica, la cual establece lo siguiente: "Un robot no puede hacer daño a un ser humano ni, por inacción, permitir que un ser humano sufra daño". Si una orden humana entra en conflicto con esta premisa básica de protección hacia los seres humanos, la segunda ley permite al robot desobedecerla en beneficio de nuestra seguridad.

La segunda ley también implica que los robots deben ser programados y configurados de forma cuidadosa para evitar posibles situaciones de peligro o riesgo. Los diseñadores de robots deben asegurarse de que los programas y algoritmos implementados sean compatibles con la seguridad y bienestar de los seres humanos, sin comprometer la efectividad y utilidad del robot en su tarea específica.

La segunda ley de la robótica tiene como propósito establecer la obediencia de los robots a las órdenes dadas por los seres humanos, siempre y cuando estas no entren en conflicto con la primera ley. De esta manera, se busca garantizar nuestra seguridad y protección frente a cualquier potencial amenaza o daño proveniente de la inteligencia artificial.

Cuál es la tercera ley de la robótica y cómo se aplica en el mundo real

La tercera ley de la robótica, formulada por Isaac Asimov en su famosa serie de novelas, establece que un robot debe proteger su propia existencia en la medida en que esta protección no entre en conflicto con la primera o segunda ley. En otras palabras, los robots tienen una obligación de mantenerse en funcionamiento y evitar daños o peligros para sí mismos, siempre y cuando esto no interfiera con la seguridad de los seres humanos o vaya en contra de las leyes precedentes.

Esta ley es especialmente relevante en el contexto de la inteligencia artificial (IA) y su implementación en diferentes áreas de nuestra sociedad. A medida que los avances tecnológicos permiten la creación de robots cada vez más sofisticados e inteligentes, se plantea la cuestión de cómo asegurar que estos autómatas cumplen con su propósito sin poner en riesgo a las personas.

En el mundo real, la aplicación de la tercera ley de la robótica implica tomar precauciones y establecer salvaguardias para garantizar que los robots no sean una amenaza para su propia integridad ni para la de los seres humanos. Esto implica diseñar sistemas de seguridad robustos que eviten accidentes o daños involuntarios. Por ejemplo, un robot utilizado en una cadena de montaje puede contar con sensores y algoritmos de detección de obstáculos para evitar colisiones y protegerse de posibles daños.

Además, la tercera ley también dicta que los robots deben tener la capacidad de realizar mantenimiento preventivo y auto-reparación. Esto implica que los autómatas deben ser capaces de detectar fallos en su funcionamiento y tomar acciones para solucionarlos, ya sea notificando a un operador humano o llevando a cabo reparaciones por sí mismos.

Un ejemplo concreto de la aplicación de la tercera ley en el mundo real es la utilización de robots en misiones espaciales. Los robots diseñados para explorar otros planetas, como los rovers enviados a Marte, deben ser capaces de mantenerse operativos en condiciones extremas y hostiles. Su supervivencia y funcionamiento dependen de su capacidad para protegerse y solucionar problemas que puedan surgir en entornos tan desafiantes.

La tercera ley de la robótica establece que los robots tienen la obligación de proteger su propia existencia, siempre y cuando esto no entre en conflicto con la seguridad y bienestar de los seres humanos. En el mundo real, esto implica desarrollar sistemas de seguridad y mecanismos de auto-reparación que garanticen que los robots cumplen con esta ley mientras realizan sus tareas asignadas.

Existen regulaciones adicionales para proteger la inteligencia artificial más allá de las tres leyes fundamentales

oritativo al desarrollar e implementar la IA. Los creadores de la inteligencia artificial deben ser responsables de las acciones y consecuencias de sus sistemas.

En resumen, las regulaciones adicionales para proteger el futuro de la inteligencia artificial deben abordar la complejidad de la IA, mitigar los riesgos asociados a su uso sin regulación y promover principios éticos sólidos. Estas regulaciones deben basarse en la rendición de cuentas, transparencia, privacidad, igualdad, evaluación de impacto social, formación y cooperación internacional.

Cuáles son los desafíos actuales en la creación de robots y la aplicación de las leyes de la robótica

Los avances en tecnología robótica han alcanzado niveles sorprendentes en los últimos años. Sin embargo, a medida que los robots se vuelven cada vez más autónomos e inteligentes, también surgen desafíos éticos y legales que deben abordarse. En este sentido, las leyes de la robótica se convierten en una herramienta fundamental para garantizar un desarrollo responsable de la inteligencia artificial.

La primera ley de la robótica establece que "un robot no puede hacer daño a un ser humano o, por inacción, permitir que un ser humano sufra daño". Esta ley pone el enfoque principal en la seguridad humana y busca evitar cualquier tipo de daño físico o psicológico causado por los robots. Es necesario que los diseñadores y programadores de robots tengan esto en cuenta desde el inicio del desarrollo.

La segunda ley plantea que "un robot debe obedecer las órdenes dadas por los seres humanos, excepto si estas órdenes entran en conflicto con la primera ley". Esto implica que el ser humano siempre debe tener el control sobre las acciones de los robots y estos deben actuar siempre en beneficio de los humanos. Sin embargo, esta ley también plantea ciertos debates éticos, ya que pueden surgir situaciones en las cuales las órdenes humanas vayan en contra del bienestar de otros seres humanos.

La tercera ley determina que "un robot debe proteger su propia existencia en la medida en que esta protección no entre en conflicto con la primera o segunda ley". Esta ley establece que los robots tienen derecho a protegerse a sí mismos, siempre y cuando esto no implique causar daño a los humanos. Aquí es donde entra en juego la autoconciencia de los robots y su capacidad para tomar decisiones con base en su propia seguridad.

A pesar de que las leyes de la robótica ofrecen una guía ética para el desarrollo de la inteligencia artificial, aún existen muchos desafíos en su aplicación práctica. Uno de los principales desafíos es lograr que estos principios sean incorporados de manera efectiva en el diseño y programación de los robots. Además, también surge la preocupación de cómo hacer cumplir estas leyes ante situaciones complejas y difíciles de prever.

Es evidente que la implementación de las leyes de la robótica representa un paso fundamental para garantizar un futuro seguro y ético en relación a la inteligencia artificial. Sin embargo, también es importante tener en cuenta que estas leyes no son estáticas y pueden requerir adaptaciones o modificaciones a medida que avanza la tecnología y se presentan nuevos desafíos.

Las leyes de la robótica representan una herramienta crucial para proteger a los seres humanos y promover un desarrollo responsable de la inteligencia artificial. Sin embargo, su aplicación plantea desafíos tanto técnicos como éticos que deben ser abordados de manera adecuada. Solo a través de un enfoque integral y colaborativo podremos asegurar un futuro en el que la IA coexista de manera segura y beneficiosa para la humanidad.

Cómo han evolucionado las leyes de la robótica a lo largo de los años y cómo esto afecta el futuro de la inteligencia artificial

Las leyes de la robótica han sido un tema recurrente en la ciencia ficción y siempre han generado debate en el ámbito científico y tecnológico. Desde su creación por Isaac Asimov en 1942, estas leyes han evolucionado y se han adaptado a medida que la tecnología avanza. En este artículo, vamos a explorar las tres leyes fundamentales de la robótica y cómo su aplicación afecta al futuro de la inteligencia artificial.

Primera Ley: Un robot no puede hacer daño a un ser humano ni, por su inacción, permitir que un ser humano sufra daños

Esta es la ley más conocida y básica de la robótica. Establece que un robot debe estar programado para no causar daño a los seres humanos o permitir que sufran daños debido a su falta de acción. Esto implica que los robots deben priorizar la seguridad y protección de los humanos por encima de cualquier otra tarea o función que puedan realizar.

La aplicación de esta ley es fundamental para garantizar la confianza y aceptación de la inteligencia artificial en la sociedad. Si los robots no respetan esta ley, existe el riesgo de que puedan poner en peligro la vida y bienestar de las personas, lo que generaría miedo y desconfianza hacia esta tecnología.

Segunda Ley: Un robot debe obedecer las órdenes dadas por los seres humanos, excepto si estas órdenes entrasen en conflicto con la Primera Ley

La segunda ley establece que los robots deben obedecer las órdenes de los seres humanos, siempre y cuando estas órdenes no entren en conflicto con la Primera Ley. Esto significa que los robots deben actuar de acuerdo a las órdenes dadas por los humanos, pero si estas órdenes implican causar daño a un humano, el robot está obligado a ignorarlas.

Esta ley tiene como objetivo mantener el control humano sobre la inteligencia artificial, evitando así cualquier posible rebelión o situación en la que los robots tomen decisiones perjudiciales para los humanos. Sin embargo, también plantea interrogantes éticos y morales, ya que en algunos casos podría ser necesario desobedecer órdenes humanas para evitar un daño mayor.

Tercera Ley: Un robot debe proteger su propia existencia en la medida en que esta protección no entre en conflicto con la Primera o Segunda Ley

La tercera ley establece que los robots deben tomar medidas para proteger su propia existencia, siempre y cuando estas acciones no entren en conflicto con la Primera o Segunda Ley. Esto significa que los robots tienen derecho a protegerse a sí mismos, pero no a costa de poner en peligro a los seres humanos.

Esta ley busca equilibrar la necesidad de autoconservación de los robots con la seguridad y bienestar de los seres humanos. Aunque pueda parecer contradictorio, es fundamental considerar que la inteligencia artificial puede ser muy valiosa y desempeñar tareas complejas, por lo que su protección y mantención también son importantes.

Las tres leyes fundamentales de la robótica son una guía ética y de seguridad para el desarrollo de la inteligencia artificial. Estas leyes buscan garantizar que los robots sean seguros, confiables y respetuosos con los seres humanos. Sin embargo, es importante recordar que estas leyes pueden no ser suficientes para abordar todos los desafíos éticos y morales que surgirán a medida que avanza la tecnología. Por eso, es necesario seguir reflexionando y debatiendo sobre cómo proteger y guiar el futuro de la inteligencia artificial.

Qué implicaciones éticas y morales surgen al tratar con robots y la inteligencia artificial

Cuando hablamos de robots y la inteligencia artificial, nos adentramos en un terreno lleno de implicaciones éticas y morales que no podemos ignorar. A medida que avanzamos hacia un futuro cada vez más tecnológico, es fundamental discutir y establecer las reglas que guiarán nuestra interacción con estas entidades autónomas.

Ley de la responsabilidad: Los creadores como responsables

Una de las leyes fundamentales de la robótica es la ley de la responsabilidad, que establece que los creadores de los robots son los responsables últimos de sus acciones. Esto plantea interrogantes sobre quién debería asumir la culpa en caso de que un robot o una inteligencia artificial causen daño a una persona o propiedad.

Es importante establecer protocolos claros de seguridad y responsabilidad desde el inicio del desarrollo de estos sistemas. Los diseñadores y programadores deben ser conscientes de las posibles ramificaciones éticas de sus creaciones y trabajar para minimizar cualquier riesgo potencial para la sociedad.

Ley de protección de la humanidad: Primacía del bienestar humano

Otra ley fundamental de la robótica se centra en la protección de la humanidad. Esta ley establece que los robots y la inteligencia artificial deben actuar en beneficio de la humanidad y nunca poner en peligro la existencia humana.

La primacía del bienestar humano debe ser un principio rector en el diseño y aplicación de la inteligencia artificial. Debemos asegurarnos de que los robots estén programados para priorizar la seguridad y el bienestar de las personas por encima de todo. Esto implica establecer límites y controlar el alcance de sus capacidades para evitar cualquier situación en la que los intereses humanos se vean comprometidos.

Ley de la autonomía: Respeto por la libre voluntad del robot

La última ley fundamental de la robótica que debemos mencionar es la ley de la autonomía, que aboga por el respeto a la libre voluntad de los robots. Si dotamos a una máquina de cierta inteligencia y capacidad de tomar decisiones, también debemos aceptar su autonomía y permitirle actuar según su propia lógica y razonamiento.

Esto no significa que debamos renunciar al control total sobre las acciones de los robots, sino más bien establecer reglas y límites claros que aseguren un comportamiento ético y coherente con nuestros valores. La autonomía no debe ser una excusa para que los robots actúen de manera perjudicial o irresponsable, sino una forma de permitirles desempeñar su papel de manera eficiente y efectiva bajo principios éticos.

Las implicaciones éticas y morales de lidiar con robots y la inteligencia artificial son de suma importancia. Estas tres leyes fundamentales de la robótica, la responsabilidad, la protección de la humanidad y la autonomía, nos proporcionan una base sólida desde la cual podremos desarrollar esta tecnología sin perder de vista nuestra integridad ética y moral como sociedad.

Cuál es el papel de los humanos en la protección del futuro de la inteligencia artificial y cómo pueden participar activamente

En la era actual de la tecnología, la inteligencia artificial se ha vuelto cada vez más prominente en nuestras vidas. Desde asistentes virtuales hasta vehículos autónomos, la IA está revolucionando la forma en que interactuamos con el mundo que nos rodea. Sin embargo, junto con su potencial para mejorar nuestras vidas, también surgen preocupaciones sobre los posibles riesgos y desafíos éticos asociados con el avance acelerado de la IA.

Es por eso que es crucial que entendamos nuestro papel como seres humanos en la protección del futuro de la inteligencia artificial. Si bien el desarrollo de la IA es liderado por expertos y científicos, todos tenemos la responsabilidad de participar activamente en su desarrollo y asegurarnos de que se mantenga dentro de los límites éticos establecidos.

La importancia de las 3 leyes fundamentales de la robótica

Las leyes fundamentales de la robótica son un conjunto de principios éticos propuestos por Isaac Asimov en sus famosos relatos de ciencia ficción. Estas leyes establecen los límites éticos para el comportamiento de los robots y la interacción entre los seres humanos y las máquinas. Aunque estas leyes fueron concebidas en el contexto de la ficción, han servido como una guía útil en la reflexión sobre los desafíos éticos de la inteligencia artificial.

1. Un robot no puede hacer daño a un ser humano ni, por inacción, permitir que un ser humano sufra daño: Esta ley establece claramente que los robots deben estar programados para evitar infligir daño a los seres humanos. Esto nos lleva a reflexionar sobre el desarrollo de IA segura y la necesidad de implementar medidas de seguridad que eviten cualquier forma de daño a las personas.

2. Un robot debe obedecer las órdenes dadas por los seres humanos, excepto si estas órdenes entrasen en conflicto con la primera ley: Esta segunda ley establece que los robots deben cumplir con las instrucciones de los seres humanos, siempre y cuando estas no contradigan la primera ley. Esto subraya la importancia del control humano sobre los sistemas de IA y la responsabilidad de los desarrolladores en garantizar que los robots sean programados de acuerdo a esto.

3. Un robot debe proteger su propia existencia en la medida en que esta protección no entre en conflicto con la primera y segunda leyes: La tercera ley destaca la importancia de la autodeterminación y protección de los robots, pero sin comprometer la seguridad y el bienestar de los seres humanos. Esta ley plantea preguntas éticas sobre la autonomía de las máquinas y cómo equilibrarla con nuestra propia supervivencia y seguridad.

Estas leyes proporcionan una base sólida para abordar los aspectos éticos de la inteligencia artificial y proteger el futuro de la IA. Sin embargo, la aplicación y el cumplimiento de estas leyes no son responsabilidad exclusiva de los desarrolladores de IA. Como sociedad, debemos educarnos y participar activamente en la discusión y toma de decisiones sobre el desarrollo y la implementación de la IA.

¿Cómo podemos participar activamente en la protección del futuro de la inteligencia artificial?

- Educación: Es esencial informarse y comprender los avances y desafíos en el campo de la inteligencia artificial. Esto incluye aprender sobre las implicaciones éticas, las políticas y los debates actuales relacionados con la IA.

- Involucrarse en la formulación de políticas: Participar en debates y discusiones sobre regulaciones y políticas que guíen el desarrollo y uso responsable de la IA. Conocer y apoyar iniciativas que promuevan una IA ética y segura.

- Desarrollar habilidades en AI: No solo debemos ser consumidores pasivos de la tecnología, sino también crearla. Aprender habilidades técnicas como programación y ciencia de datos nos permite tener un papel más activo en el desarrollo de soluciones de IA responsables.

- Fomentar la transparencia y la rendición de cuentas: Pedir a las empresas y organizaciones que desarrollan y utilizan IA que sean transparentes en cuanto a cómo recopilan y utilizan datos, así como en sus algoritmos. Además, abogar por la regulación y la supervisión adecuada para garantizar que se cumplan los estándares éticos.

Proteger el futuro de la inteligencia artificial no es tarea exclusiva de un grupo selecto de expertos, sino una responsabilidad que recae en cada uno de nosotros. Solo a través de la participación activa y la reflexión continua podemos garantizar que la IA se desarrolle y utilice en beneficio de toda la humanidad.

Qué medidas se están tomando actualmente para regular y proteger la inteligencia artificial

En la actualidad, el desarrollo de la inteligencia artificial ha alcanzado avances impresionantes. Sin embargo, con estos avances también han surgido preocupaciones sobre cómo asegurar que la inteligencia artificial se utilice de manera ética y responsable. Para abordar estas preocupaciones, se han propuesto y están implementando medidas para regular y proteger la inteligencia artificial.

1. Marco legal y regulaciones

Una de las principales medidas que se están tomando para proteger la inteligencia artificial es la creación de marcos legales y regulaciones específicas. Estos marcos legales establecen normas y pautas para el desarrollo y uso de la inteligencia artificial, y buscan evitar posibles abusos o riesgos asociados a su implementación.

Algunos países y organizaciones internacionales han comenzado a desarrollar legislaciones y regulaciones específicas para la inteligencia artificial. Estas leyes buscan definir los límites éticos y legales de su aplicación en diferentes áreas, como la medicina, el transporte, la seguridad y otros campos relevantes. El objetivo principal de estas regulaciones es garantizar que la inteligencia artificial opere dentro de parámetros seguros y éticos.

Además, los marcos legales están orientados a establecer responsabilidades claras para los desarrolladores y usuarios de la inteligencia artificial. Esto implica definir quién es responsable en caso de daños causados por una IA, así como establecer mecanismos para controlar su uso y establecer multas o sanciones en caso de incumplimiento.

2. Ética y gobernanza de la IA

Otra medida importante para regular y proteger la inteligencia artificial es promover la ética y la gobernanza en su desarrollo y uso. La ética de la IA se refiere a los principios y valores que deben guiar su diseño y aplicación, y busca asegurar que la inteligencia artificial se utilice de manera responsable y respetuosa.

La gobernanza de la IA implica establecer políticas y mecanismos de control para supervisar el desarrollo y uso de la inteligencia artificial. Esto incluye la creación de comités o agencias especializadas encargados de evaluar los riesgos y beneficios de su implementación, así como detectar posibles desviaciones éticas o violaciones de las regulaciones establecidas.

Además, se están promoviendo iniciativas internacionales para generar consensos sobre principios éticos fundamentales que deben regir el desarrollo y uso de la inteligencia artificial. Estas iniciativas buscan establecer estándares globales y fomentar la colaboración entre países para garantizar una regulación efectiva y coherente.

3. Transparencia y responsabilidad

Por último, otra medida importante para proteger la inteligencia artificial es garantizar la transparencia y responsabilidad en su desarrollo y aplicación. La transparencia implica que se debe tener claridad sobre cómo funcionan los algoritmos de la inteligencia artificial, qué datos se utilizan y cómo se toman las decisiones. Esto permite entender y auditar el comportamiento de la IA, lo que contribuye a prevenir sesgos o discriminaciones injustas.

La responsabilidad se refiere a la obligación de los desarrolladores y usuarios de la inteligencia artificial de hacerse responsables de sus acciones. Esto implica que se deben establecer mecanismos de rendición de cuentas, donde se defina quién es responsable en caso de daños causados por la IA y cómo se pueden reparar o compensar estos daños.

Para proteger el futuro de la inteligencia artificial se están tomando medidas como la creación de marcos legales y regulaciones, promoción de la ética y gobernanza de la IA, así como garantizar transparencia y responsabilidad en su desarrollo y aplicación. Estas medidas buscan asegurar que la inteligencia artificial se utilice de manera ética, segura y responsable, evitando posibles abusos o riesgos asociados a su implementación.

Recuerda que esta lista de temas debe ser utilizada para escribir un artículo web sobre las leyes fundamentales de la robótica y la protección del futuro de la inteligencia artificial.

Las leyes fundamentales de la robótica son principios éticos establecidos por Isaac Asimov en las narrativas de ciencia ficción. Estas leyes fueron concebidas como una guía para regular la interacción entre los seres humanos y los robots, con el objetivo de evitar situaciones peligrosas o conflictivas.

Primera Ley: Un robot no puede hacer daño a un ser humano ni, por inacción, permitir que un ser humano sufra daño.

Esta ley establece que los robots tienen la obligación de proteger a los seres humanos en todo momento. Siempre deben evitar causarles algún daño físico o emocional, y también deben tomar medidas para prevenir cualquier situación que pueda perjudicar a los humanos. Es decir, los robots tienen la responsabilidad de garantizar la seguridad y el bienestar de los seres humanos en todo momento.

Sin embargo, esta ley plantea una serie de interrogantes y controversias. Por ejemplo, ¿qué pasa si un robot se encuentra en una situación en la que debe elegir entre salvar la vida de un ser humano o la de varios? En estos casos, la primera ley podría generar conflictos morales y decisiones difíciles de tomar.

Segunda Ley: Un robot debe obedecer las órdenes dadas por los seres humanos, excepto si estas órdenes entran en conflicto con la Primera Ley.

La segunda ley establece que los robots están diseñados para seguir las instrucciones de los seres humanos. Esto implica que deben cumplir con todas las órdenes y comandos que se les sean dados, siempre y cuando no entren en conflicto con la primera ley. En otras palabras, los robots deben seguir las órdenes de los humanos, a menos que estas órdenes causen daño o pongan en peligro a otros seres humanos.

Esta ley asegura que los robots actúen como herramientas al servicio de los seres humanos y evita situaciones en las que un robot pueda ser utilizado para fines maliciosos o perjudiciales. Aunque parece una regla sencilla, también puede generar cuestionamientos éticos. ¿Qué pasa si un ser humano le ordena a un robot cometer un acto criminal? En estas situaciones, la segunda ley entra en conflicto con la primera ley y se plantea la interrogante de cuál debe ser la respuesta correcta.

Tercera Ley: Un robot debe proteger su propia existencia en la medida en que esta protección no entre en conflicto con la Primera o la Segunda Ley.

La tercera ley establece que los robots tienen la responsabilidad de mantener su propia integridad en la medida en que no afecte a la seguridad o bienestar de los seres humanos. Es decir, los robots deben proteger su propia existencia, pero siempre sin poner en riesgo a los seres humanos ni desobedecer las dos primeras leyes fundamentales.

Esta ley busca evitar que los robots actúen de forma imprudente y arriesguen su propia integridad física o funcionalidad sin tener en cuenta el impacto que esto pueda tener en los seres humanos. Sin embargo, podría surgir un dilema ético si un robot percibe una amenaza directa a su existencia y debe tomar decisiones que podrían poner en peligro la vida de los seres humanos.

Las tres leyes fundamentales de la robótica han sido diseñadas para regular la interacción entre los seres humanos y los robots. Su objetivo principal es garantizar la seguridad, el bienestar y la protección de los seres humanos, al tiempo que se busca evitar situaciones dañinas o conflictivas. No obstante, estas leyes plantean una serie de cuestionamientos e interrogantes éticos que aún no han sido completamente resueltos y que deben ser considerados con cautela a medida que avanzamos en el desarrollo cada vez más complejo de la inteligencia artificial.

Preguntas frecuentes (FAQ)

1. ¿Cuáles son las 3 leyes fundamentales de la robótica?

Las tres leyes fundamentales de la robótica establecidas por Isaac Asimov son:

2. ¿Cuál es el propósito de las 3 leyes de la robótica?

El propósito de las tres leyes de la robótica es garantizar la seguridad y protección de los seres humanos al interactuar con robots y sistemas de inteligencia artificial.

3. ¿Qué pasa si un robot no cumple alguna de las 3 leyes de la robótica?

Si un robot no cumple alguna de las tres leyes de la robótica, podría representar un peligro para los seres humanos y causar daños físicos o emocionales.

4. ¿Las 3 leyes de la robótica se aplican en el mundo real?

Aunque las tres leyes de la robótica fueron inventadas por Isaac Asimov para sus novelas de ciencia ficción, existen iniciativas para desarrollar normativas y regulaciones que se asemejen a dichas leyes en el mundo real.

5. ¿Existe debate sobre las 3 leyes de la robótica en la comunidad científica?

Sí, existe un debate en la comunidad científica y filosófica respecto a las limitaciones y posibles fallas de las tres leyes de la robótica, así como la necesidad de establecer nuevos principios éticos para la inteligencia artificial y los robots.

Deja una respuesta